访问 Hdfs

1.从hadoop安装目录中取下列jar文件(请根据实际所用版本取对应的jar文件,下列为hadoop2.6.5版本对应的jar),放到产品外部库文件夹中;Hdfs外部库文件路径为:安装目录\ esProc\extlib\ HdfsFileCli;润乾核心jar为hdfsfilecli.jar。

commons-cli-1.2.jar

commons-collections-3.2.2.jar

commons-configuration-1.6.jar

commons-lang-2.6.jar

guava-11.0.2.jar

hadoop-auth-2.6.5.jar

hadoop-common-2.6.5.jar

hadoop-hdfs-2.6.5.jar

hadoop-mapreduce-client-core-2.6.5.jar

hadoop-mapreduce-client-jobclient-2.6.5.jar

htrace-core-3.0.4.jar

log4j-1.2.17.jar

protobuf-java-2.5.0.jar

slf4j-api-1.7.5.jar

slf4j-log4j12-1.7.5.jar

注意:

hadoop2.8.3版本除上列jar外还需以下2个jar:hadoop-hdfs-client-2.8.3.jar、htrace-core4-4.0.1-incubating.jar

hadoop3.0.0版本除上列jar外还需以下5个jar:hadoop-client-runtime-3.0.0、hadoop-hdfs-client-3.0.0.jar、htrace-core4-4.1.0-incubating.jar、stax2-api-3.1.4.jar、woodstox-core-5.0.3.jar

并且hadoop为高版本时需要使用commons-configuration2-2.1.1.jar代替低版本的commons-configuration-1.6.jar

2.从网上下载以下四个文件,放到:安装目录\bin下

hadoop.dll

hadoop.lib

libwinutils.lib

winutils.exe

注意:windows环境下需要以上四个文件,Linux环境中不需要,并且winutils.exe区分x86与x64。

3. java环境要求为jre1.7及以上版本,集算器自带的版本为jre1.6,所以需要用户自己安装高版本jre。并在:安装目录\ esProc\bin\config.txt文件中配置java_home。如果用户在安装集算器时,已选择1.7及以上版本的jdk,则此步可以省略。

4.当占用内存比较大时,用户可自己调整内存,目前windows下有两种方式,使用exe启动时在config.txt里修改内存,使用bat启动时是在bat文件中修改内存。Linux下是在sh文件中修改内存大小。

在windows下修改config.txt方法如下:

java_home=C:\ProgramFiles\Java\jdk1.7.0_11;esproc_port=48773;jvm_args=-Xms256m -XX:PermSize=256M -XX:MaxPermSize=512M -Xmx9783m -Duser.language=zh

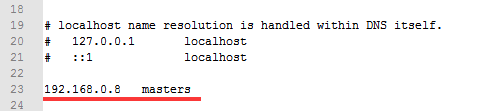

5.在集算器所在机器中,找到hosts文件,添加hdfs所在机器的IP地址与主机名称,例如hdfs服务所在机器的IP为192.168.0.8,主机名为:masters,那么如下图设置:

6.访问Hdfs可使用的外部库函数有hdfsfile()、hdfs_client()、hdfs_close()、hdfs_file()、hdfs_dir()等。函数用法请参考【帮助】-【函数参考】